sci论文中的科研数据处理方法

不直接参与科研的人都觉得科研是一种充满了新idea和思想碰撞的活动。可是那只是整个科研过程中的一小部分。相信所有已经做过科研的人,不管你在哪一个科研领域,在你的成果足够写成论文之前都避免不了进行大量的重复性机械性的工作。这些看上去并没有技术含量的工作有相当一部分便是数据处理了。做大热点的方向,随便做点东西就能发很好文章的人毕竟是少数。大部分科研人员,尤其是刚入门的新手,都需要做系统重复的实验,和处理大量的数据来提高工作的可靠性和质量。在这些过程中,高效处理自己的科研数据往往会有意想不到的效果。

而利用的简单的代码和编程来自动化数据处理则往往会意想不到的节约大量数据处理的时间。写代码处理数据的本质就是把模式化的过程自动化。对于编程不熟悉的同学可能初期要花费一些时间写出相应代码,可是这些短期的时间投入是绝对值得的。举个简单的例子,假设你有3000条数据存在一个文本文件里,每一行代表了某一个时间的一次实验以及结果,而你现在需要把其中的包含特定结果的500条给找出来,然后做一些数学运算。如果你仅仅依靠手动复制黏贴处理这类问题,轻轻松松几个小时就过去了。假设你的科研工作经常需要处理这样的数据,可能你会有无数个烦躁的下午在做机械的工作,而且还可能会出错。可是如果你懂一些脚本语言,比如linux下的grep, awk, sed,做这个工作可能只需要一行代码。

假设你现在手上有一个excel表格里面是自己的仪器输出的实验数据,你突然需要把每个子表中的特定的行列提取出来做一些计算排序然后后作图。正常的做法就是进入每个字表手动复制黏贴,然后处理,后用excel或者导出到origin之类的软件作图。可是只要你会任意一种编程语言,这个也就是几句代码的事。相信每一个做科研的人都学过基本的编程语言,比如c/c++, java, matlab, 或者python。只需要一些编程的基础知识,或许由于对编程的不熟悉第一次可能要花费一个下午去写好这样的可能只有十几行或者几十行的一个处理数据的脚本,可是你今后再碰见类似的问题只需要花几秒钟再次运行你的代码。

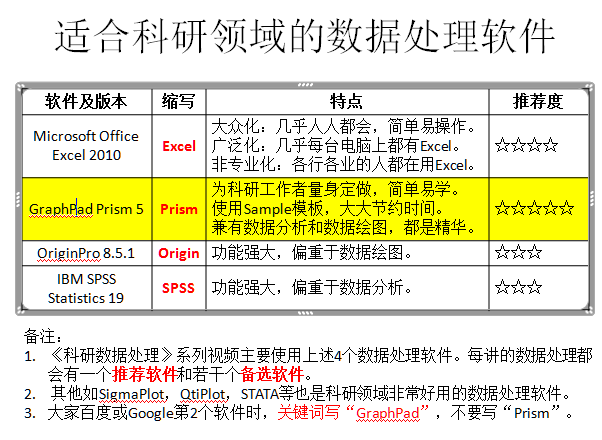

扯了这么多,推荐一些简单的做数据处理,归类的工具和编程语言吧。

首先,Linux下面有大量这样的语言和工具,而且即使你是windows用户也没关系,装一个cygwin就好了,cygwin就是一个应用程序,可以让你在不安装Linux系统,也不用繁琐的去弄虚拟机的情况下5min获得Linux使用体验。Linux下面的一些小工具比如grep, sed, awk, vim,合理的结合一些循环指令就能很快的处理完一个大型的文本文件。感兴趣的同学可以看看以下的几个链接:

Bash: http://tldp.org/LDP/Bash-Beginners-Guide/html/

vi/vim: https://www.cs.colostate.edu/helpdocs/vi.html

grep: https://www.techonthenet.com/linux/commands/grep.php

sed: http://www.grymoire.com/Unix/Sed.html

awk: https://www.tutorialspoint.com/unix_commands/awk.htm

其次,如果你会一点matlab或者python。问题也很简单,二者都有很强大的I/O模块用于读取各类信息,包括文本文件,excel表格,数据库文件,网页,PDF文件等等。你需要做的只是搜索比如“matlab如何读excel文件”然后花一点时间看看那句代码怎么写就够了。

-

论文打印要求是什么,单面还是双面? 132273

-

ieee论文什么水平,含金量如何? 71473

-

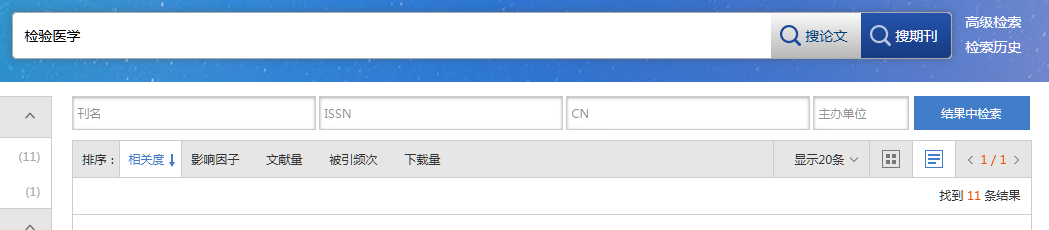

医学检验期刊有哪些?论文发表难吗? 2019.11.15 17:25

-

医药卫生省级期刊发表的要求以及投稿渠道 2019.11.15 16:32

-

预防医学核心期刊发表的经验 2019.11.15 15:26

-

中国内镜杂志期刊发表的投稿要求 2019.11.15 14:32

-

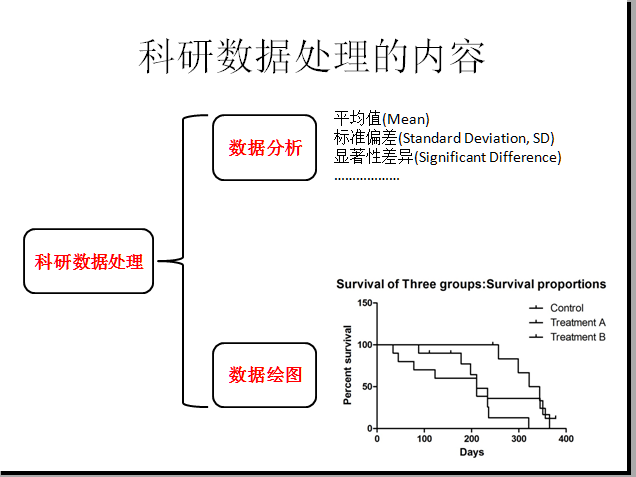

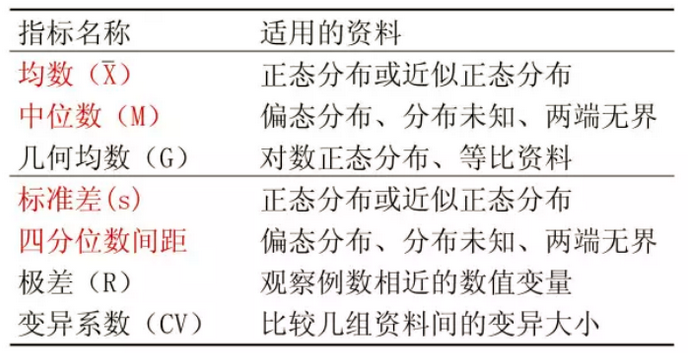

科研论文中的数据分类方法

科研论文中的数据分类方法 -

SCI论文中的常用语法句式

-

医学论文选题技巧分享

-

如何利用Photoshop转换图片格式

如何利用Photoshop转换图片格式